AI大模型发展太快了,几乎一两个月一个变化。这些模型的惊人表现,不断刷新我们对AI能力的认知。在我们为这些模型的能力震惊的时候,一个核心问题常被忽视。那就是落地场景在哪里,如果要在一些业务场景中落地,那么AI的幻觉问题如何解决?这个问题实际上被无数次的讨论过,并且答案也非常的一致,那就是垂直领域数据是关键。没有高质量、多样化的数据,再优秀的模型架构也只是空壳。业务场景落地,不要调入调参和架构优化的误区。

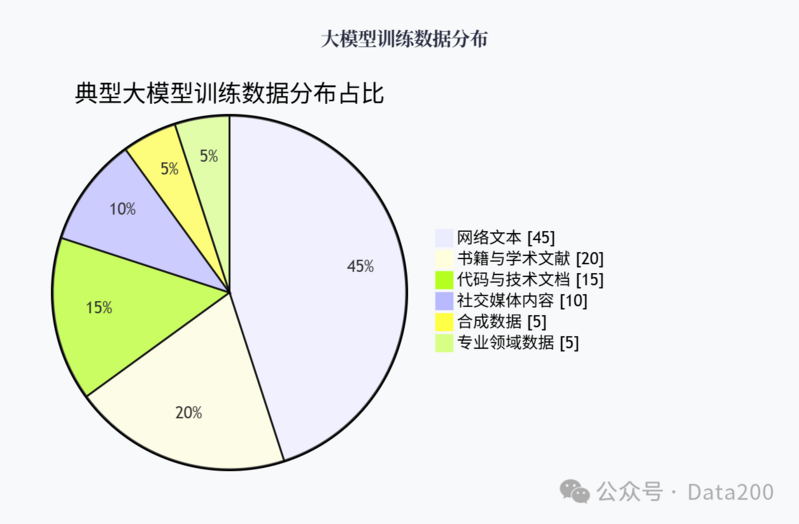

我们多次听到互联网上的数据已经不够用了,AI大模型所需的数据已经被消耗完了,导致很多大模型训练不得不使用AI生成的数据来进行训练。那么真的是数据不够了吗?并非如此,而是很多公网数据已经消耗完了,而很多业务领域的专业数据,被阻挡在了大模型之外,当然这也是很多企业的核心高价值资产。如何将这一类高价值数据转化成企业资产,则是大模型下一阶段发展的关键所在。

一、数据来源与采集方法

1.公共网络抓取技术与实践

说到大模型训练数据,不得不提CommonCrawl这个"网络巨兽"。它作为目前最大的公开网页语料库,几乎成了所有主流大模型的基础数据源。CommonCrawl已积累了约580TB的原始数据,净文本内容约26TB。

但别被这个数字吓到,原始的CommonCrawl质量参差不齐,直接用它训练出来的模型性能会很差劲。因此,各家公司都会对它进行严格筛选。以C4(ColossalClean CrawledCorpus)为例,Google通过一系列过滤:语言检测、句子长度验证、词汇检测、特殊符号移除等,最终只保留了原始数据的约15%。

除了网页抓取,社交媒体平台如Reddit、Twitter以及专业网站如GitHub、ArXiv等也是重要的数据来源。这些平台数据的特点是互动性强、时效性高,但采集时必须遵守平台的API限制和条款。

2.垂直领域数据整合

虽然通用网络数据体量庞大,但垂直领域的数据往往更有价值。就拿医疗领域来说,PubMed的学术论文、医院的临床记录(脱敏后)以及医学教科书等,对训练医疗大模型至关重要。这些垂直数据虽然体量不大,但质量高、专业性强,是通用爬虫无法获取到的。

多语言支持也是一个很关键的问题。中文数据集的构建就特别有挑战性,不仅要平衡简体与繁体,还要考虑方言、网络用语等问题。有团队花了近6个月时间仅用于中文语料的筛选与处理,这个过程的复杂性远超预期。

垂直领域数据与通用数据的比例平衡也很关键。过度偏向专业领域会导致模型在日常对话中表现晦涩难懂;而过度偏向通用数据又会使模型在专业领域知识不足。经验表明,7:3的通用与专业数据比例往往是个不错的比例,但具体还需根据场景调整。

3.合成数据生成与增强

近两年,基于已有LLM生成训练数据的方法越来越流行,这确实是个高性价比的思路,模型生成的问答对、知识归纳、逻辑推理等数据可以有效弥补真实世界数据的不足。比如,使用已有模型对原始文本进行改写、扩展、问答转化,能大大增强数据的利用效率。

合成数据也存在明显的问题,它可能会放大原始模型的错误或偏见,甚至产生"模型近亲繁殖"的问题。一般的解决方案是:将合成数据限制在总数据集的20%以内,并确保合成过程受到多重验证。

二、数据预处理与清洗策略

1.去重与冗余处理技术进展

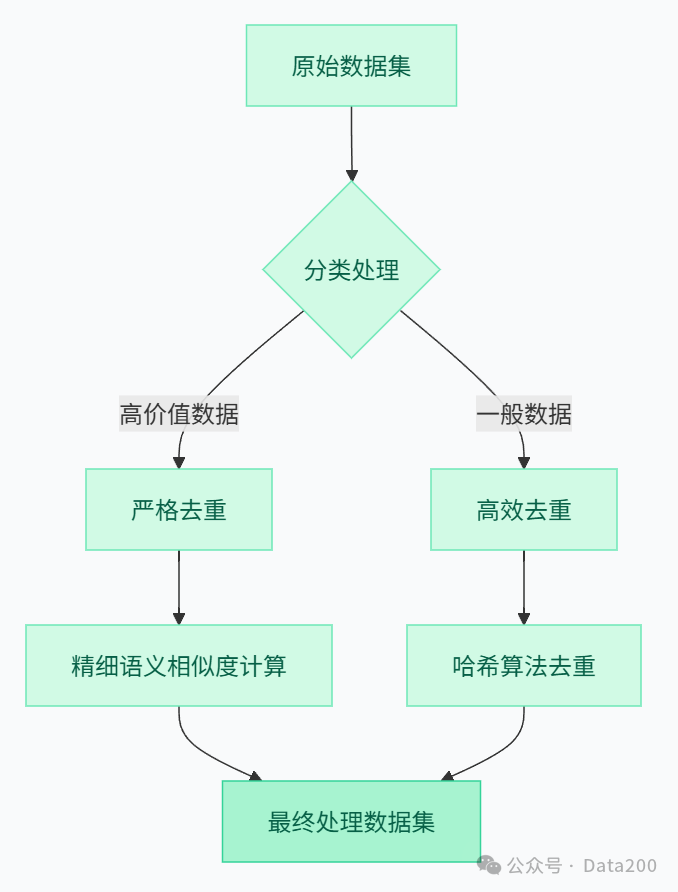

数据去重最容易被忽视,却又最影响模型效果的环节。如果训练集中某个网页被重复了100次,模型就会过度拟合这部分内容,这就会导致这部分内容的参数被加强了。

去重分为两个层次:文档级去重和模块级去重。前者相对简单,通过URL或文档哈希就能实现;后者则要复杂得多,需要考虑语义级别的相似性。在实践中,一般推荐混合策略:先用MinHash或SimHash等算法进行粗筛,再用更精细的语义相似度计算(如BERT嵌入距离)进行精筛。

一般工程实现中,会在效率和准确性之间做权衡。对于PB级别的数据集,语义去重计算成本太高,此时可以采用分层策略:对高价值数据源(如学术论文)进行严格去重,对一般数据源(如网页)则采用更高效但略粗糙的去重方法。这种方式是最具性价比的选择。

2.质量分级与数据加权

数据质量是个多维度问题,不能简单用"好"与"坏"来区分。实践中,通常会构建一个评分系统,综合考虑以下因素:

来源可靠性(如知名网站vs无名博客)

内容完整性(是否有明显缺失)

语言规范性(语法、拼写、格式等)

信息密度(是否包含大量冗余表达)

时效性(内容是否过时)

基于这些维度,可以给每条数据打分并分级。更重要的是,这些分级可以直接转化为训练时的采样权重,高质量数据被采样概率更高。很多团队忽略了这一点,只做了分级而没有在训练中体现出来。

通过调整数据权重(增加高质量学术文献与精选书籍的权重),就能使模型在知识密集型任务上的表现提升了近5-8%,而代码量只增加了不到100行。这种投入产出比是模型架构优化难以企及的。

3.多模态数据清洗与对齐

多模态数据(如图文对)的清洗更是一个技术活。以LAION-5B数据集为例,使用CLIP模型计算图像与文本的相似度,剔除了大量不匹配的样本。但即使这样,该数据集中仍有相当比例的噪声样本(估计约15-20%)。

在多模态清洗中,有三个核心步骤:

1.模态内清洗:分别清理图像(模糊、低质、不当内容)和文本(语法错误、无意义文本)

2.模态间对齐验证:确保图文语义一致性

3.整体质量评估:综合判断样本对的信息价值

在实际工程中,上述过程通常需要分布式处理,否则处理100万级别的图文对都需要数周时间。一般建议使用采样验证的方式:先处理一小部分数据,人工审核效果,再调整参数扩大到全量数据。

三、数据集构建的核心标准

1.多样性保障体系

多样性是大模型数据集的生命线,没有多样性,模型就会沦为"井底之蛙"。但多样性不是随机性,而是有结构、有目的的多元化。

在实际操作中,一般会从以下维度量化数据集的多样性:

主题分布:使用主题模型(如LDA)分析文本的主题覆盖

语言风格:正式vs口语,技术vs通俗,叙述vs对话等

知识领域:科学、艺术、历史、技术等不同领域的均衡

来源多样:不同作者、出版商、网站的分布

有一个有趣的发现:多样性与下游任务性能并非简单的正相关。在某些专业任务上,适度降低多样性,增加相关领域数据比例反而效果更好。所以,评估多样性时要结合具体应用场景,不能一味追求形式上的多元性。

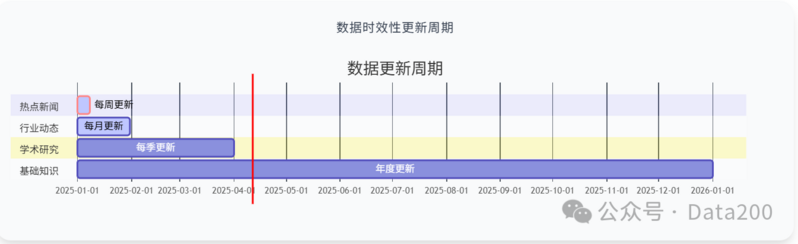

2.时效性维护机制

大模型的"知识截止日"问题一直备受诟病。解决这个问题,关键在于建立持续更新的数据摄入机制。通常采用分层更新策略:

每周:更新热点新闻、社交媒体热门话题

每月:更新专业博客、科技动态、行业报告

每季:更新学术研究、专业书籍、政策法规

每年:更新基础知识体系、历史性资料

增量学习vs全量更新的选择也很重要。理论上,增量学习效率更高;但实践中,它可能导致新旧知识间的冲突。一般建议是,对时效性强的内容采用增量学习,对基础知识采用定期全量更新。这种混合策略在效率和效果之间取得了较好平衡。

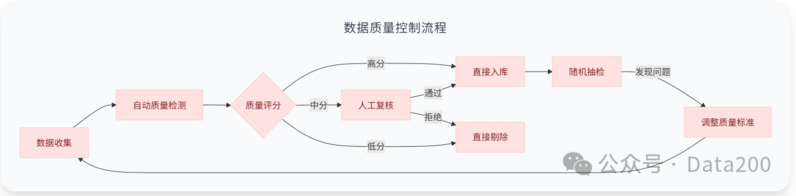

3.质量一致性

数据质量参差不齐是大多数团队面临的痛点。尤其当数据来源多元化时,不同来源间的质量差异会导致模型表现不稳定。为此,建立统一的质量标准至关重要。

基于多年经验,一般有效的质量控制体系应包括:

明确的质量标准文档:详细规定各类数据的质量要求

多级筛选流程:自动检测→初级人工→专家复核

随机抽检机制:定期抽查已入库数据,及时发现问题

质量评分反馈:将质量评估结果反馈给数据收集环节

人工审核与自动检测的结合是必不可少的。虽然人工成本高,但在关键环节引入人工验证能大幅提升整体质量。有的团队为了省钱完全依赖自动检测,结果模型出现了严重的事实性错误,最终付出了更大的代价来修复问题。

四、多模态与跨领域数据融合

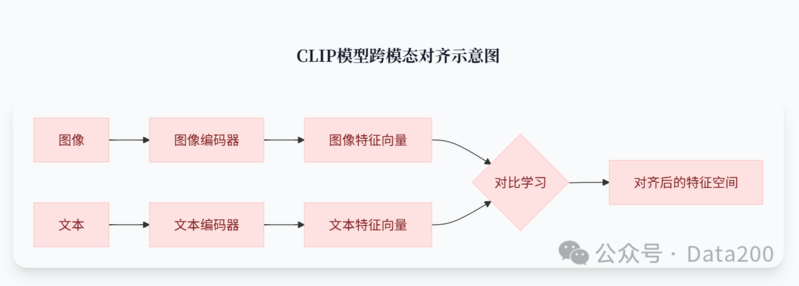

1.跨模态对齐核心技术

随着多模态的兴起,如何有效融合不同模态的数据成为新的问题。核心问题在于,不同模态(文本、图像、音频等)的表示空间差异巨大,如何将它们"对齐"到同一语义空间。

目前最主流的方法是基于对比学习的表示对齐,如CLIP模型采用的方法。简单来说,就是训练神经网络将配对的跨模态数据(如图文对)映射到相似的向量表示,使得语义相近的内容在表示空间中距离更近。

这种对齐不仅需要大量高质量的模态对数据,还需要精心设计的损失函数和训练策略。一般的经验是,模态对齐最好采用分阶段策略:先在各个模态内部学习良好表示,再进行跨模态对齐,最后进行端到端微调。这样能显著提高对齐效果和训练稳定性。

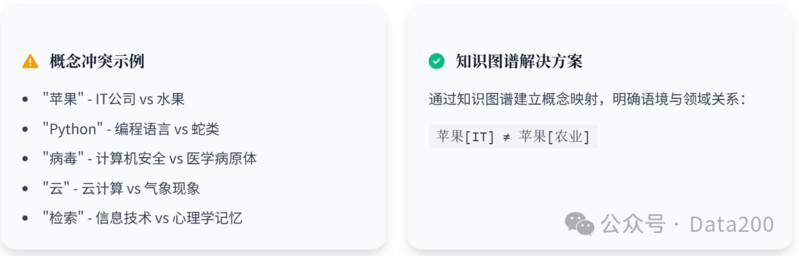

2.跨领域知识融合策略

跨领域知识融合面临的最大挑战是术语和概念的不一致性。例如,"苹果"在IT领域和农业领域有完全不同的含义。这种一词多义现象如果处理不当,会导致模型产生混淆。

知识图谱辅助的语义统一是个有效方法。通过构建跨领域的概念映射网络,可以明确不同领域间概念的对应关系。虽然这需要大量专家参与,但投入是值得的,它能从根本上提升模型的知识一致性。

此外,领域适应技术也很关键。当融合新领域数据时,不能简单堆砌,而应考虑现有知识体系与新领域的差异,采用渐进式融合策略。之前了解到一个项目,在已训好的通用模型基础上直接注入大量医学数据,结果医学能力没提升多少,反而破坏了原有的通用能力。这就是典型的融合不当导致的灾难。

3.融合挑战与解决方案

数据异构性是融合过程中的主要障碍。不同来源的数据往往有不同的格式、结构和标准,直接合并会产生一堆"四不像"。推荐采用统一的数据模型和转换流程,将各类数据先标准化,再进行融合。

语义一致性保障也很重要。当多源数据存在冲突时(如不同来源对同一事实的描述不一),需要建立冲突检测和解决机制。通常采用"可信度加权"策略,基于来源的权威性为冲突信息赋予不同权重,优先保留更可靠来源的信息。

最后,别忽视计算效率与存储优化。随着数据规模增长,处理效率成为瓶颈。很多项目在小规模数据上表现良好的融合方案,扩展到TB级别时就彻底崩溃了。所以,方案设计之初就要考虑可扩展性,采用增量处理、分布式计算等技术来保障大规模数据的处理能力。

五、数据质量评估体系

1.基础质量指标与方法

数据质量评估是个系统工程,需要多维度指标共同把关。在基础层面,通常关注以下几个核心指标:

准确性是首要指标,可通过人工抽样验证或交叉引用来评估。准确性评分与数据来源的权威性并非完全正相关,有些权威来源也会出现令人尴尬的错误,这提醒我们不能盲目信任所谓的"权威"。

连贯性是评估文本流畅度的关键指标,通常使用语言模型的困惑度(Perplexity)来量化。但困惑度并非完美指标,有些高度专业的文本可能困惑度较高,但实际质量很好。因此,我建议将困惑度与领域标签结合使用,针对不同领域设置不同的阈值。

覆盖率与均衡性量化更多关注宏观层面,评估数据集对不同主题、风格和领域的覆盖情况。可以开发了一套自动评估工具,通过主题建模和语义聚类分析数据分布,识别潜在的覆盖盲点。

2.高级语义质量评估

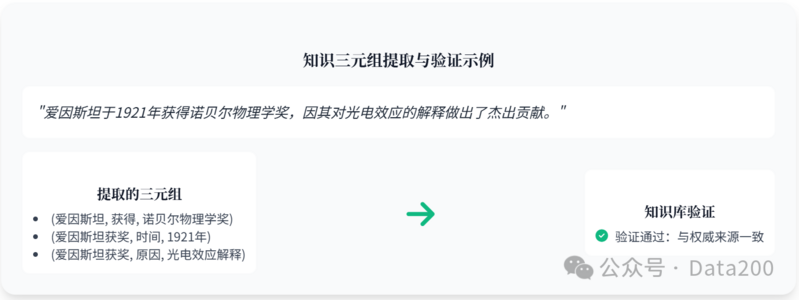

随着模型能力提升,数据质量评估也需要升级到语义层面。知识一致性验证是其中的难点,如何判断大规模数据集中的事实陈述是否一致?一般采用基于知识图谱的验证方法,提取文本中的事实三元组,与权威知识库对比,发现并标记潜在的矛盾点。

对齐度量化在多模态数据中尤为重要。除了使用CLIP等模型计算图文相似度外,还可以引入基于注意力机制的细粒度对齐评估,分析文本中的实体是否与图像中的对象对应,这比简单的整体相似度更能发现细节问题。

偏见与公平性检测是AI伦理中的热点。可以构建一套敏感词库和情境测试集,自动扫描数据中可能存在的性别、种族、宗教等方面的偏见表达。虽然这增加了处理成本,但考虑到潜在的社会影响和声誉风险,这种投入是必要的。

3.动态质量监控机制

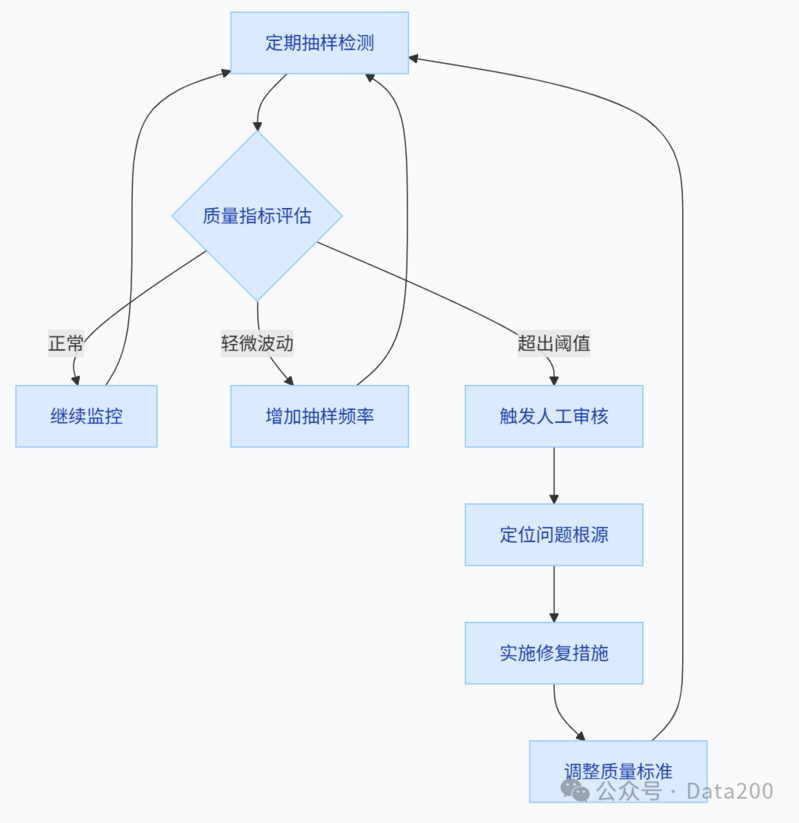

静态评估只是第一步,持续的动态监控才能确保数据质量长期稳定。可以实施质量巡检机制,定期对数据集进行抽样评估,对比不同时期的质量指标变化。这种纵向比较能及时发现质量退化问题。

问题追踪与反馈循环也很关键。当发现质量问题时,不仅要修正问题本身,还要追溯根源,分析是哪个环节出了问题,避免类似问题再次发生。要将数据质量管理提升到流程和制度层面,而非仅仅依靠技术手段。

质量预警与干预系统是数据工程的重要部分。设置多级预警阈值,当质量指标波动超过警戒线时,自动触发人工审核和干预流程。这种机制可以帮助我们及时发现并修复批量数据错误,避免了灾难性后果。

六、中文大模型数据集现状

中文大模型数据集构建面临独特挑战。相比英文,中文互联网内容质量参差不齐,高质量学术资源相对稀缺。此外,中文分词的复杂性也增加了预处理难度。

在通用中文语料整合上,平衡各类来源至关重要。新闻、百科、社交媒体、学术论文、政府文件等不同来源各有特点,需要谨慎混合。特别是网络文学和社交媒体内容,虽然语言活泼多样,但也常包含低质量表达和错误信息,使用时需要更严格的过滤。

对话与指令数据是中文模型的薄弱环节。国内高质量的问答语料相对缺乏,而这恰恰是训练指令跟随能力的关键。一般会考虑三种解决方案:1)比如从客服记录中提取高质量对话;2)翻译并本地化英文指令数据;3)基于现有模型合成指令数据。实践表明,混合使用这三种方法效果最佳,但本土原创的优质指令数据仍是稀缺资源。

中文特有语言现象处理也需特别关注。网络用语、方言表达、简繁转换、古文引用等都是中文特有的挑战。需要开发了专门的处理模块,如网络用语规范化、简繁智能转换等,以提升中文语料的规范性和一致性。在一些创意场景下,适当保留方言和网络用语反而能增强模型的表达活力,这需要根据应用场景灵活处理。

最后

我们正从算法为王转向数据为王的新阶段。架构创新固然重要,但在模型架构日趋同质化的今天,数据质量和多样性正成为决定性因素。我敢断言,未来几年,数据集将成为大模型之间的真正护城河,谁能构建更优质、更独特的数据资源,谁就能在竞争中占据先机。